Wie wir mit Maschinen kommunizieren

Die Forschung zur Mensch-Maschine-Kommunikation habe in den letzten Jahren bedeutende Fortschritte gemacht, erzählt der Informatiker David Ahlström. Mit uns hat er über Stolpersteine und Verbesserungspotenziale für die Zukunft gesprochen.

Herr Ahlström, ich bin mit der Bedienung meiner technischen Geräte – Smartphone, Tablet, Laptop – vollauf zufrieden und wüsste nicht, was es hier noch zu tun gäbe. Haben Sie in Ihrer Forschung überhaupt noch etwas zu tun?

Ahlström (lacht): Das ist etwas, das ich auch meine Studierenden immer wieder frage. Warum brauchen wir das Forschungsgebiet Mensch-Maschine-Kommunikation, wenn es ohnehin schon sehr gut läuft? Wir müssen dabei aber sehen: Es war ein langer Weg, bis wir zu dem heutigen Resultat gekommen sind. Für den alltäglichen Benutzer bzw. die Benutzerin scheint heute vieles leicht und gut zu funktionieren. Wir orten in der Forschung aber auch noch einige Stolpersteine, die es zu bewältigen gibt. Das sind in vielen Bereichen nur Nischenthemen, deren Bearbeitung aber trotzdem für viele lohnend sein könnte.

In welche Richtung geht es dabei?

Die Grundidee ist: Die Verständigung zwischen Mensch und Maschine soll so nahtlos wie möglich funktionieren. Das Gerät soll dabei den Menschen verstehen. Es soll immer weniger nötig werden, dass sich der Mensch an die technischen Anforderungen der Maschine anpasst.

Das sind ungewöhnliche Worte für einen Informatiker, für den doch häufig die Technik im Vordergrund steht. Woher rührt dieser Blickwinkel?

Computer haben mich schon nicht interessiert, als ich mich für das Informatik-Studium entschieden habe. Sie interessieren mich auch heute noch nicht wirklich. Ich sehe sie als Werkzeuge, die funktionieren sollen. Das ist meine Erwartung an sie. Ursprünglich wollte ich Lehrer für „Technisches Werken“ werden, als aber die Aufnahmeprüfung an der Kunstuni in meiner schwedischen Heimat anstand, gab ich der zeitgleich stattfindenden Abschlussreise des Militärdiensts den Vorzug, und so kam es, dass ich zuerst vorübergehend, dann aber doch endgültig bei der Informatik landete. Die Interaktion zwischen Mensch und Maschine hat viel mit visueller Kommunikation zu tun. Das künstlerisch-kulturelle Interesse daran passte dann doch irgendwie zu meinem späteren Forschungsthema.

Wo sehen Sie noch Stolpersteine bei der Benutzung von alltäglich gewordenen Geräten?

Stellen Sie sich vor, Sie bewegen sich auf der Straße, mit Kind oder Tragetaschen im Arm, die Verkehrssituation, ihre nächsten Wege, die Passantinnen und Passanten im Blick. Ihr Smartphone klingelt. Es wäre in dieser Situation für Sie von Vorteil, wenn Sie den Anruf beantworten könnten, ohne dabei auf Ihr Handy zu blicken. Es wäre für Sie also in dieser Situation gut, irgendwo am Bildschirm über das Display streichen zu können und damit den Anruf anzunehmen. Diese Idee könnte man auch weiterführen und sagen, dass es reichen müsste, in der Nähe eines Smartphones eine bestimmte Bewegung zu machen, die eine entsprechende Reaktion des Geräts auslösen würde. Solche Gesten für die Steuerung zu nutzen, könnte in vielen Bereichen sinnvoll sein.

Was bräuchte man dafür?

Dafür müssten andere Sensoren im Gerät eingebaut werden, beispielsweise Kameras, die zur Objekterkennung in der Lage wären. Dann könnte so ein Gerät meine Hände und die Gesten, die ich ausführe, erkennen. Es wäre sogar möglich, dass das Gerät erkennt, welche Objekte ich als Benutzer ertaste.

Wofür wäre eine solche Funktion einsetzbar?

Ich nenne ein Beispiel: Ich bin kürzlich in eine ältere Wohnung eingezogen, in der die Lichtschalter und Steckdosen an denkbar ungünstigen Positionen platziert sind. Die Lichtschalter würden sich in Zukunft durch eine smarte Lösung ersetzen lassen. Es könnte kleine 3D-Streifen geben, auf denen ein bestimmtes Muster aufgedruckt ist. Diese werden ganz einfach an den Wänden dort aufgeklebt, wo ich einen Lichtschalter gut brauchen könnte. Streiche ich dann mit meinem Finger über einen solchen 3D-Streifen, erkennt das Steuerungsgerät, dass ich das Licht einschalten will. Außerdem weiß das Gerät auch, dass ich das Licht in einer bestimmten Helligkeitsstufe gedimmt haben will. Streicht aber meine Freundin über diesen 3D-Streifen, weiß die Maschine auch um ihre Lichtvorlieben und schaltet die Lampen in einer anderen Helligkeitsstufe ein.

Wie funktioniert das?

Um in diese Richtung zu forschen, braucht es bestimmte Sensoren. Wir arbeiten mit Beschleunigungssensoren, mit denen sich auch Vibrationen messen lassen. Wenn man beispielsweise neben einem Handy auf den Tisch klopft, kann das Gerät die Vibrationen erkennen. Das funktioniert auch, wenn ich bestimmte Oberflächen abtaste. Bei solchen Entwicklungen müssen wir uns aber auch stets fragen, wofür wir solche Anwendungen bauen wollen: Was geht technisch, aber auch: Was ist für den Menschen möglich, machbar, gewünscht und praktisch?

Gibt es Bereiche, wo stärker nicht die technischen Möglichkeiten das Angebot vorantreiben, sondern die Bedürfnisse des Menschen?

Ja, das betrifft vor allem den Bereich der visuellen Kommunikation. Wenn es darum geht zu entscheiden, was ich wie auf einem Bildschirm anzeige sowie welche Farben, Symbole und Kontraste ich wähle, steht meist der Mensch am Beginn des Entwicklungsprozesses. Ein sinnvoll gestalteter Bildschirm muss klar und eindeutig zum Ausdruck bringen, was die Maschine vom Menschen verlangt. Dazu braucht es eine enge Zusammenarbeit zwischen Designern und zukünftigen Benutzerinnen sowie viele Studien, wo zukünftige BenutzerInnen unterschiedliche Designvorschläge testen und bewerten.

Ein großer Smartphonehersteller hat kürzlich angekündigt, die aus Science-Fiction-Filmen bekannten Hologramme auf die mobilen Geräte zu bringen. Halten Sie das für realistisch?

Bei solchen Entwicklungen müssen wir uns auch immer wieder fragen: Wollen wir das? Und wofür? Beispielsweise wäre eine Besprechung mit Menschen, die sich physisch am anderen Ende der Welt befinden, so noch leichter umzusetzen. Wenn ein Raum mit Kameras an den Wänden oder an der Decke ausgestattet ist, können diese Kameras schon heute millimetergenau ausmessen, wo sich mein Finger bewegt und welche Befehle ich damit erteile. Diese Funktion mobil anzubieten, stelle ich mir allerdings schwerer vor. Außerdem ist der Bereich der Anwendungen eher gering: Will ich in der Öffentlichkeit mit meiner Hologramm-Mutter telefonieren? Da verhält es sich ähnlich wie mit der Sprachsteuerung, die eine bestimmte – meist leise, private – Umgebung braucht, um sinnvoll einsetzbar zu sein.

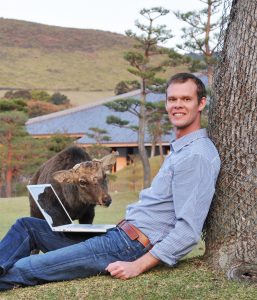

Zur Person

David Ahlström ist assoziierter Professor am Institut für Informatik-Systeme. Er studierte Informatik an der Universität in Stockholm, Schweden. Nach einem ERASMUS-Austauschjahr an der Universität Wien und seinem Abschluss arbeitete er für zwei Jahre für Siemens in Wien und kam danach an die Universität Klagenfurt. Im Jahr 2008 war er als Schrödinger-Stipendiat des österreichischen Wissenschaftsfonds FWF an der University of Canterbury (Neuseeland). Im Jahr 2015 habilitierte er sich zum Thema Mensch-Maschine-Kommunikation. Zuletzt forschte und lehrte Ahlström auch an der University of Manitoba (Kanada). Seine Forschungsschwerpunkte sind: Graphische Benutzerschnittstellen, Interaktionsmechanismen, Interaktive Systeme, Grafik und Gestaltung sowie Interaktionsdesign.